L'IA che decide per noi: quali sfide etiche?

Una riflessione sul rischio di disumanizzazione e perdita di controllo

di Francesco Pungitore*

Gli algoritmi di decisione rappresentano il nucleo centrale dell'intelligenza artificiale, progettati per emulare e talvolta superare la capacità umana nell'assumere scelte basate su vasti insiemi di dati. Questi modelli sono costruiti su principi matematici e logici che consentono di elaborare informazioni, identificare modelli e fare previsioni o suggerimenti. Si distinguono principalmente in tre categorie: l'apprendimento supervisionato, dove l'algoritmo impara da un insieme di dati già etichettato; l'apprendimento non supervisionato, che identifica modelli in dati non etichettati; e l'apprendimento per rinforzo, in cui l'algoritmo si perfeziona tramite il feedback ricevuto dalle sue decisioni.

Il processo di decisione di un algoritmo inizia dalla raccolta dei dati, che sono la base su cui opera. Dopo la raccolta, i dati vengono analizzati e utilizzati per costruire un modello decisionale attraverso tecniche come la classificazione, la regressione o il clustering. Il modello viene poi testato e validato per garantirne l'accuratezza, spesso attraverso un processo di apprendimento continuo che si adatta ai nuovi dati.

Gli algoritmi di decisione trovano già applicazione in diversi ambiti, dal settore finanziario, dove sono impiegati per analisi di rischio e prevenzione delle frodi, alla medicina per la diagnosi assistita e la personalizzazione delle cure, fino al settore dei trasporti in sistemi di navigazione e veicoli autonomi. Ma nonostante la loro vasta applicabilità, gli algoritmi di decisione presentano significative limitazioni. Innanzitutto, il bias presente nei dati di allenamento può portare a decisioni distorte. Per esempio, immaginiamo un sistema IA impiegato nella selezione del personale. Se l'insieme di dati usato per addestrare questo sistema include prevalentemente candidati maschi selezionati per posizioni tecniche, l'algoritmo potrebbe sviluppare una tendenza a favorire questo genere per ruoli simili. Una conseguenza non dovuta a una predisposizione intrinseca dell'IA, ma riflesso dei pregiudizi impliciti nei dati di partenza. Di conseguenza, candidate donne, anche se altamente qualificate, potrebbero essere ingiustamente escluse, perpetuando una disparità di genere. Tale esempio evidenzia come il bias nei dati possa influenzare decisioni cruciali.

Inoltre, molti algoritmi di IA, in particolare quelli basati su reti neurali profonde, mancano di trasparenza e sono difficili da interpretare, guadagnandosi l'etichetta di “scatole nere”. Questo solleva interrogativi sulla loro affidabilità, soprattutto quando vengono applicati in contesti critici. In conclusione, il loro uso porta con sé questioni complesse riguardanti l'etica, la sicurezza e l'impatto sociale.

Responsabilità morale: chi è colpevole quando un'IA sbaglia?

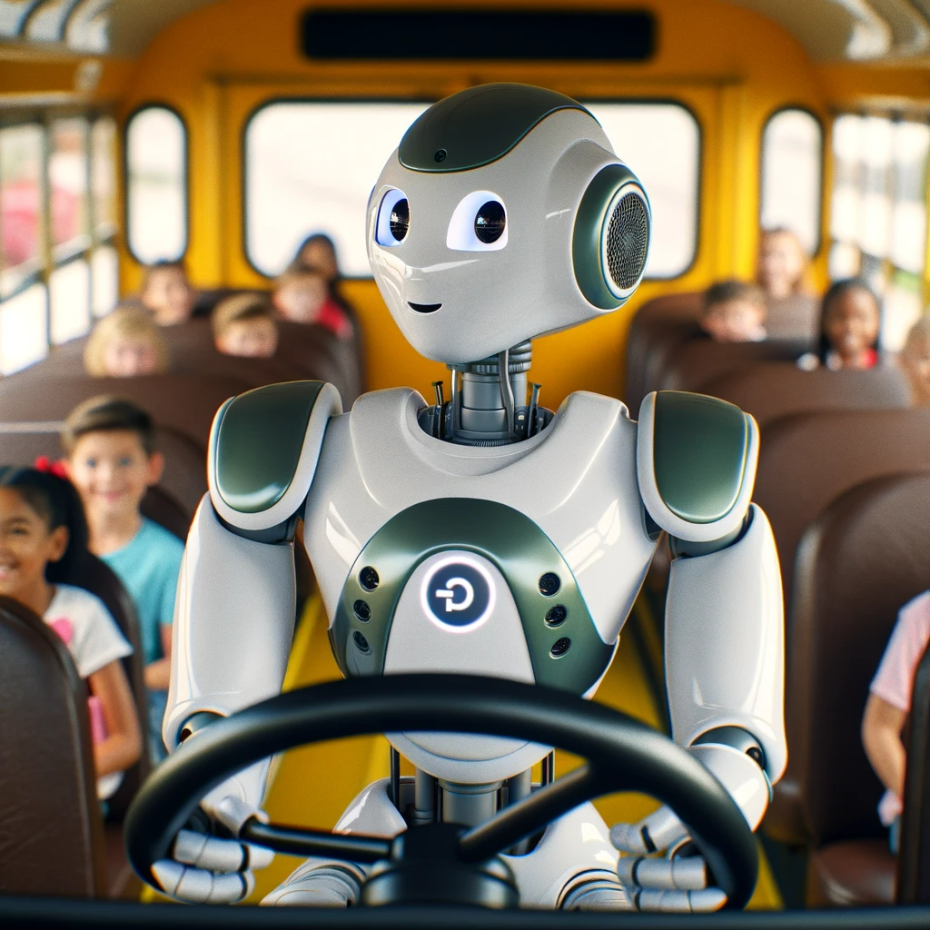

La questione della responsabilità morale in situazioni in cui un'IA compie errori è particolarmente complessa e diventa ancora più spinosa quando si tratta di scenari di vita o di morte, come quelli che coinvolgono veicoli a guida autonoma. Un classico esempio è il dilemma etico che si presenta quando una macchina deve scegliere, in una situazione di emergenza, tra causare danno a un anziano o a un bambino, con una probabilità del 50% per ciascuno.

In questi casi, l'IA deve prendere una decisione basata su algoritmi predeterminati che, in teoria, valutano le conseguenze possibili e scelgono l'opzione che minimizza il danno. Tuttavia, ogni scelta programmata in questi scenari solleva domande profonde sulla moralità delle decisioni prese dalle macchine: è eticamente accettabile programmare un'IA per fare scelte di vita o di morte basate su criteri come l'età o altre caratteristiche umane?

La responsabilità per le azioni dell'IA diventa un labirinto di complessità. Se un'IA fa una scelta sbagliata, di chi è la responsabilità? Ricade sul produttore dell'auto per come ha programmato l'algoritmo? Sugli ingegneri che hanno sviluppato il software? O sull'IA stessa, che ha preso la decisione finale? Alcuni sostengono che il peso morale e legale dovrebbe essere attribuito agli sviluppatori e ai produttori dell'IA, poiché sono loro a definire i parametri decisionali dell'algoritmo. Altri, invece, suggeriscono una redistribuzione della responsabilità, includendo gli utenti finali o i regolatori che approvano tali tecnologie.

Questo dilemma evidenzia non solo le sfide tecniche nella progettazione di sistemi IA sicuri ed efficienti, ma anche la necessità di un quadro etico e legale robusto che possa guidare e regolamentare lo sviluppo e l'uso dell'intelligenza artificiale in contesti critici. In breve, la soluzione a queste domande richiede quantomeno un approccio multidisciplinare.

Casi di studio

L'implementazione dell'intelligenza artificiale in settori cruciali come la giustizia, la medicina e l'ambito economico e politico solleva una serie di interrogativi etici e di sfide sociali particolarmente significative. Nel campo della giustizia, per esempio, i sistemi predittivi di IA vengono utilizzati per valutare la probabilità di recidiva di un imputato o per guidare le decisioni sui rilasci condizionali. Sebbene questi modelli possano aumentare l'efficienza, esiste il rischio che i pregiudizi nei dati di allenamento portino a valutazioni ingiuste, specialmente per gruppi sociali minoritari.

Analogamente, nell'ambito medico, l'IA è impiegata per supportare decisioni diagnostiche o terapeutiche, potendo però generare dilemmi etici riguardo alla trasparenza delle decisioni prese e alla possibile perdita del rapporto umano nella cura del paziente. Un aspetto di riflessione che solleva preoccupazioni sul ruolo dell'IA come assistente o sostituto del giudizio medico.

Infine, l'impiego dell'IA in economia, ad esempio nella previsione delle tendenze di mercato o nell'analisi del sentiment politico, può avere un impatto sociale profondo, influenzando decisioni che riguardano l'allocazione delle risorse o le scelte di nazioni e privati. In tutti questi contesti, le decisioni dell’IA possono portare benefici significativi in termini di efficienza e capacità analitica, ma richiedono un'attenta valutazione dei rischi etici e degli impatti sociali, per garantire che non perpetuino disuguaglianze o non compromettano valori umani fondamentali.

Conclusioni

La prospettiva futura dell'intelligenza artificiale si configura come un terreno fertile di potenzialità rivoluzionarie, insieme a rischi e sfide etiche considerevoli. Come già sottolineato da Stuart Russell e Peter Norvig nel loro testo “Artificial Intelligence: a modern approach”, l'IA non è solo un'impresa tecnologica, ma anche un profondo richiamo alle questioni del nostro essere oltre che dell'umanità in generale. Gli sviluppi dell'IA promettono miglioramenti senza precedenti in diversi settori, dall'assistenza sanitaria alla gestione delle risorse ambientali. Tuttavia, come avvertiva già Norbert Wiener, il padre della cibernetica, in “God & Golem, Inc.”, il progresso tecnologico senza un'adeguata riflessione etica può portare a conseguenze indesiderate, incluso il rischio di disumanizzazione e perdita di controllo.

In questo contesto, la formulazione di politiche per una gestione etica dell'IA diventa imperativa. Dobbiamo orientarci verso un approccio che, come suggerisce Nick Bostrom nel suo “Superintelligenza”, preveda una sinergia tra progresso tecnologico e valori umani fondamentali. Questo implica la creazione di quadri normativi e linee guida etiche che garantiscano lo sviluppo di sistemi IA responsabili, trasparenti e inclusivi. La sfida è duplice: da un lato, garantire che l'IA sia al nostro servizio e rispetti i diritti umani; dall'altro, assicurare che la sua integrazione nella società non esalti disuguaglianze o pregiudizi.

In conclusione, l'avvento dell'IA rappresenta un momento cruciale nella storia dell'umanità, un'opportunità per riflettere non solo su ciò che la tecnologia “può” fare, ma anche su ciò che “deve” fare. Come affermato da Fei-Fei Li, una pioniera nell'IA: “Se vogliamo che la tecnologia rifletta l'intera umanità, deve essere guidata dall'intera umanità”. La strada da percorrere richiede un dialogo continuo, un impegno condiviso tra scienziati, filosofi, politici e cittadini, per assicurare che gli sviluppi della ricerca si allineino con una visione di progresso equo e sostenibile.

*giornalista professionista, docente di Filosofia, Storia, Scienze Umane e Tecniche di Comunicazione con Perfezionamento post-laurea in Tecnologie per l’Insegnamento e Master in Comunicazione Digitale. Direttore Tecnico dell’Osservatorio Nazionale Minori e Intelligenza Artificiale